فایل robots چیست و چگونه آن را بسازیم

فایل robots چیست و چگونه آن را بسازیم

- آموزشی, خدمات سایت, مقالات

- مائده جلیلی

فایل robots چیست و چگونه آن را بسازیم

یکی از سادهترین فایلها در وبسایت robots است. اما یکی از نکات مهمی ک وجود دارد این است که در عین سادگی میتواند سئو سایت را تخریب کند. جالب است بدانید؛ یک کاراکتر جابهجا میتواند سئو را خراب کند. سپس موتورهای جستجو را از دسترسی به محتوای مهم سایت شما باز دارد. پس با ما همراه باشید تا بدانیم فایل robots چیست و چگونه آن را بسازیم.

شما میتوانید بعد از اتمام این مطالب، مقالهی اصول و مفاهیم سئوی سایت را مطالعه کنید.

فایل robots.txt

یک فایل ساده متنی است که میتوانید روی سرور خود قرار داده تا نحوه دسترسی رباتها به صفحهی شما را کنترل کند. در واقع قوانینی برای خزندهها ایجاد میکند تا تعیین کند که کدام صفحات باید خزیده شوند یا نشوند. فایل باید در دایرکتوری ریشه وب سایت شما قرار گیرد. برای مثال، اگر وب سایت شما macanads.com نام دارد، فایل robots.txt باید در macanads.com/robots.txt باشد. خزندهها برنامههایی هستند که در وب میخزند. موتورهای جستجو از آنها برای یافتن محتوای وب برای ایندکس استفاده میکنند. مراحل این فرآیند به شرح زیر است :

- خزندهها دارای صفی از URLها هستند. هم وبسایتهای جدید و هم قبلاً شناخته شده را میخزند.

- قبل از خزیدن یک وب سایت، خزندهها ابتدا به دنبال فایل robots.txt در دایرکتوری ریشه وب سایت میگردند.

- اگر هیچ فایل robots.txt وجود نداشته باشد، خزندهها آزادانه وب سایت را میخزند. با این حال، اگر یک فایل robots.txt معتبر وجود داشته باشد، خزندهها به دنبال دستورالعملها در داخل آن میگردند و بر این اساس به خزیدن وبسایت ادامه میدهند.

- اگر یک موتور جستجو نتواند صفحه را بخزد، آن صفحه نمیتواند ایندکس شود و در نتیجه در صفحات نتایج جستجو ظاهر نمیشود.

اهمیت robots در سئو

در سئو برای بهینه سازی و افزایش رتبه سایت در موتورهای جستجو مخصوصا گوگل روشهای مختلفی وجود دارد. یکی از روشهای قدیمی و مهم در صفحات سایت فایل robots است. با این فایل میتوانید یک سری از دستورات مهم را به موتورهای جستجو بفهمانید. robots جزء سئو داخلی سایت محسوب میشود. زیرا تغییرات و اعمال آن بر روی صفحات سایت به شکل کامل در دست مدیر و یا مشاور سئو سایت میباشد.

شما میتوانید برای کسب اطلاعات بیشتر در مورد ابزارهای google search console، مقالهی معرفی کامل گوگل سرچ کنسول را مطالعه کنید.

دستورات robots

no index

با این دستور میتوانیم به رباتها دستور دهیم که صفحه ایندکس نشود. نکتهای که وجود دارد این است که اگر آگاهی کامل از ایندکس نشدن صفحات خوددارید از دستور no index استفاده کنید.

index

این دستور برعکس دستور no index عمل میکند. در واقع به معنی اجازه دسترسی برای ایندکس کردن صفحات را دارند.

no follow

این دستور یعنی هیچیک از لینکها را رباتهای موتورهای جستجو دنبال نکنند ولی لینک نوفالو صرفاً برای یک لینک بهکار برده میشود.

follow

این دستور برعکس دستور قبل است. در واقع به موتورهای جستجو اعلام میکند که لینکهای موجود در صفحه را دنبال کند.

none

این دستور مثل دستورات no index و no follow عمل میکند. شما همچنین میتوانید از این دو دستور برای ایندکس نکردن استفاده کنید. هرچند به شکل کلی توصیه نمیشود ولی با آگاهی کامل از این دستورات استفاده کنید.

no image index

اسپایدرهای موتورهای جستجو (همان رباتها) با این دستور اجازه دسترسی به عکسهای صفحات را نخواهند داشت. البته اگر عکسی در جای دیگر لینک شده باشد موتور جستجو میتواند آن را ایندکس کند.

no translate

این دستور مخصوص ربات گوگل است. در واقع اجازه نمیدهد ربات گوگل SERP ترجمهای انجام دهد.

no archive

این دستور برای این است که که موتورهای جستجو نسخهای از صفحات شما را در کش خود قرار ندهند.

no cache

همان کار دستور no archive را میکند ولی دستور no cache فقط برای موتور جستجوی MSN/Live اعمال میشود.

no snippet

اگر مایلید توضیحات نوشته یا همان تگ Description را در نتایج جستجو نمایش ندهید از این دستور استفاده کنید.

noodp

کار این دستور عدم نمایش توضیحات سایت ما که در سایتهای دایرکتوری مثل dmoz وجود دارند را در نتایج جستجو است. به این معنی که سایت dmoz از هر سایتی یک سری اطلاعات جمعآوری میکند و ممکن است موتورهای جستجو در نتایج از آن اطلاعات در زیر لینکهای سایت ما استفاده کنند. هرچند دیگر سایت dmoz فعالیتی انجام نمیدهد. به سایتهای دایرکتوری اصولا ODP گفته میشود.

noydir

این دستور میگوید که هیچ موتورجستجویی از توضیحات سایت من که در دایرکتوری یاهو است در نتایج استفاده نکند. در واقع مثل دستور noodp عمل میکند ولی برای دایرکتوری سایت یاهو که امروزه منسوخ شده است.

چگونه یک فایل robots بسازیم؟

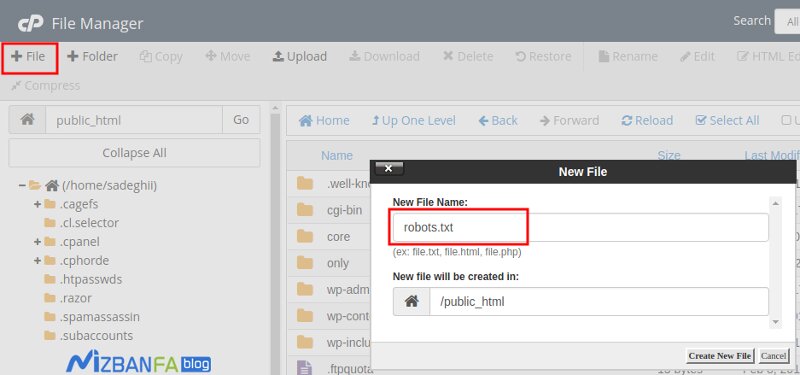

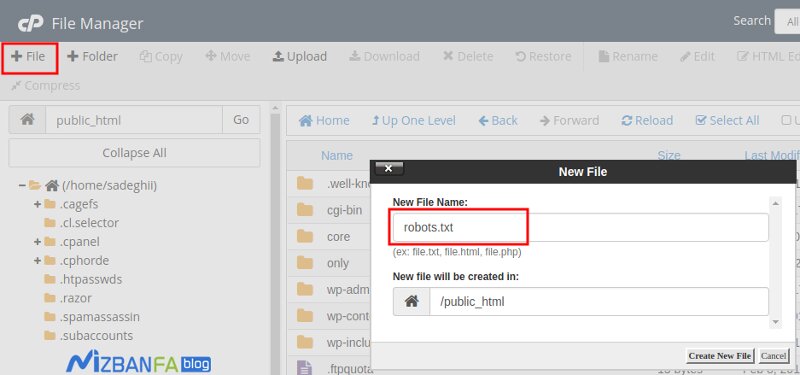

برای ساخت فایل robots.txt وردپرس ابتدا وارد هاست خود شده و روی File Manager کلیک کنید. با این کار میتوانید فایلهای موجود در هاست را کنترل کنید. سپس به مسیر /public_html/ مراجعه کنید تا به مسیری که وردپرس در آن نصب است برسید. اگر وردپرس روی دامنهی اصلی شما نصب شده است؛ کافیست در همین مسیر باشید. در غیر این صورت باید وارد همان پوشه از هاست خود شوید. حالا که به مسیر درست رسیدید با استفاده از برنامه notepad یا هر نرمافزار ویرایشگر متن که دارید یک فایل با نام robots.txt با همین فرمت بسازید و با کلیک روی دکمه آپلود در File Manager هاست آن را به این مسیر اضافه کنید. یا میتوانید با کلیک روی FILE+ پنجرهای به شکل زیر داشته باشید:

در اینجا نام فیلد را در New File Name با نام robots.txt وارد کنید و در نهایت روی دکمه Create New File کلیک کنید تا فایل شما ساخته شود. حالا که فایل را ایجاد کردید بر اساس توضیحات زیر میتوانید دسترسی برای موتورهای جستجو توسط این فایل را به پوشههای مختلف از هاست خود کنترل کنید. توجه داشته باشید که فایل robots.txt یک فایل متنی با فرمت txt میباشد. در نتیجه شما نمیتوانید از دستوراتی که در زبانهایی مثل HTML و CSS استفاده کنید؛ بلکه باید هر دستور را در یک سطر وارد کنید و اینکه در این فایل شما صرفا محدود به چند دستور ساده هستید. دو فایل کلی که از این دستور پیروی میکنند برایتان در ادامه شرح میدهیم:

Disallow:

این دستور نشان میدهد که ربات اجازه ورود به چه مسیرهایی از هاست شما را خواهد داشت.

User_ agent:

این دستور تعیین میکند چه نوع رباتی قادر به دسترسی به دایرکتوریهای تعیین شده در هاست شما خواهد بود. منظور از نوع ربات این است که ربات کدام سایت یا موتور جستجو میتواند از این دستور پیروی کند.

در نهایت شما میتوانید با استفاده از این دو دستور قوانین مختلفی را برای هریک از رباتهای موتورهای جستجو و سایتها تعیین کنید تا عدم دسترسی به دایرکتوریهای گوناگون در هاست خود را تعیین کنید. با استفاده از دستور User_ agent میتوانید یک قانون برای یک ربات خاص یا رباتها تعیین کنید.

به عنوان مثال اگر شما در هاست خود پوشهای به نام macanads دارید و قصد دارید دسترسی به این پوشه برای کلیهی رباتها فراهم نباشد؛ کافیست در سطر اول User_ agent را وارد کرده و مقدار آن را روی کاراکتر * تعیین کنید. سپس با دستور Disallow:/macanads/دسترسی به این پوشه را برای کل رباتها غیرفعال کنید. در این صورت اگر رباتی وارد سایت شما شود از این قانون تبعیت کرده و وارد پوشه macanads در هاست شما نخواهد شد. برای این کار کافیست روی فایل robots.txt که در هاست شما قرار دارد راست کلیک کرده و گزینه Edit را انتخاب کنید.

مشکل Page actions are temporarily disabled در سرچ کنسول گوگل

مجموعه ماکان با یک تیم تخصصی در زمینهی ارتقای سئوی سایت میتواند همراه شما باشد و سایت شما را در صدر جستجوهای گوگل قرار دهد. جهت کسب اطلاعات بیشتر و همکاری با ما تماس بگیرید.

- Google Search Console, robots, robots.txt, User_ agent چیست, ابزار سئو, ابزار گوگل سرچ کنسول, ابزارهای سئو, ارتقای سئوی سایت, اهمیت سئو, ایندکس شدن صفحات, تاثیر فایل robots روی سئو, خطاهای page not index, ربات, رفع خطاهای page not index, سئو, ساختن robots, ساختن ربات, ساختن فایل robots, طریقه ساخت فایل robots, فایل robots, فایل robots چیست, گوگل سرچ کنسول

جدیدترین مقالات

مقالات تصادفی

انتخاب آژانس تبلیغاتی

8 نکته برای انتخاب آژانس تبلیغاتی امروزه کانون های تبلیغاتی بسیاری در زمینه دیجیتال مارکتینگ و بازاریابی فعالیت میکنند و

طراحی سایت حرفه ای

ویژگی های طراحی سایت حرفه ای طراحی سایت سالهاست که به یک اصل در تجارت تبدیل شده است. هر کسب

معرفی ابزارهای هوش مصنوعی تبدیل صدا به ویدیو

معرفی ابزارهای هوش مصنوعی تبدیل صدا به ویدیو با گسترش محتواهای ویدیویی در فضای دیجیتال، تبدیل صدا به ویدیو یکی

دلایل پنالتی شدن و رفع پنالتی گوگل

دلایل پنالتی شدن و رفع پنالتی گوگل یکی از بدترین اتفاقهایی که ممکن است برای شما رخ دهد، پیبردن به